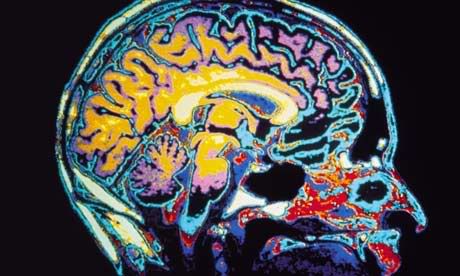

Observando el patrón de actividad del cerebro, los científicos han descubierto que pueden “leer” si una persona está oyendo palabras pronunciadas con enfado, alegría, alivio o tristeza. El estudio, que aparece publicado en Current Biology, es el primero en mostrar que la información emocional está representada por firmas espaciales definidas en el cerebro y, esto es lo interesante, generalizables para las distintas personas que puedan pronunciar esas palabras.

La interpretación correcta de la emoción en la voz es muy importante, especialmente en los entornos actuales en los que la información visual no siempre está presente, como al hablar por teléfono.

Thomas Ethofer de

Estudios anteriores de neuroimagen habían mostrado que las áreas auditivas sensibles a la voz se activan más cuando se expresan emociones vocalmente que cuando se oye un discurso neutro. Sin embargo esta activación era independiente del tipo de emoción expresada, lo que hacía imposible distinguir entre distintas emociones con análisis convencionales.

En el nuevo estudio, los investigadores hicieron que distintas personas oyeran pseudopalabras (suenan como palabras pero no significan nada) expresadas de cinco formas distintas: con enfado, tristeza, alivio, alegría o sin emoción. Mientras, sus cerebros estaban siendo escaneados con imagen por resonancia magnética funcional (IRMf).

Los resultados fueron analizados aplicando un método llamado análisis multivariado de patrones al patrón espacial completo de la actividad. Habitualmente lo que se analiza es cada punto del cerebro separadamente.

Los resultados fueron concluyentes: podían clasificar cada emoción frente a todas las demás alternativas.

Hemos de recordar en este punto el resultado que el año pasado publicó el equipo de Tom Mitchell de

Más información:

“Decoding of Emotional Information in Voice-Sensitive Cortices”; Ethofer et al.; Current Biology, 14 May 2009; doi:10.1016/j.cub.2009.04.054

No hay comentarios:

Publicar un comentario